Jihoon Kim

AI Research Engineer

I’m Jihoon Kim, an AI Research Engineer specializing in generative AI and human motion synthesis. Currently, I work as an AI research engineer at Cinamon. Previously, I worked at KakaoBrain and Ailys Co., Ltd.

news

| Feb 06, 2023 | I started to work as an AI Research Engineer at Cinamon. |

|---|---|

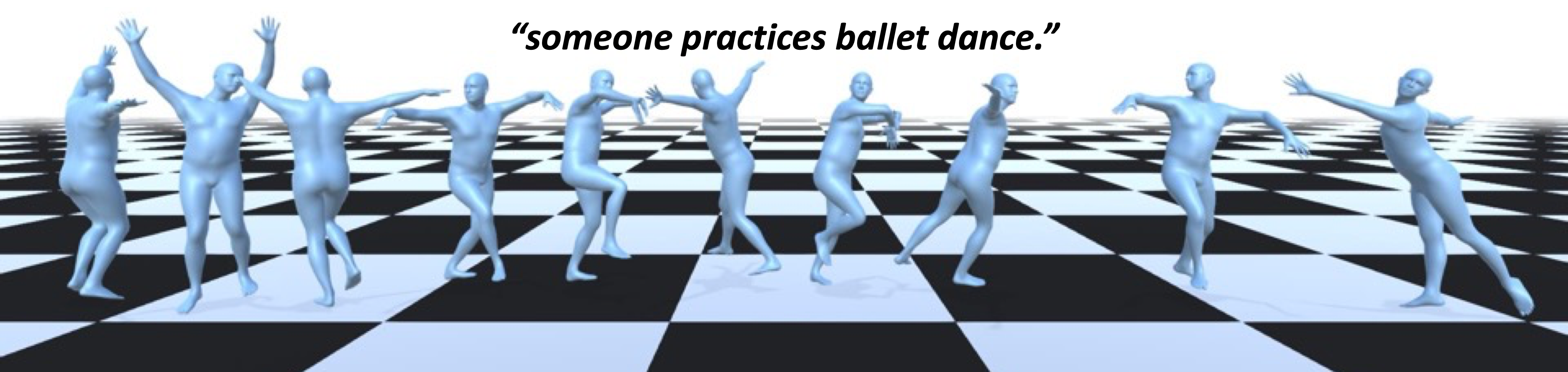

| Jan 11, 2023 | Our paper FLAME: Free-form Language-based Motion Synthesis & Editing has been accepted for an oral presentation at the Association for the Advancement of Artificial Intelligence (AAAI) 2023 conference. |

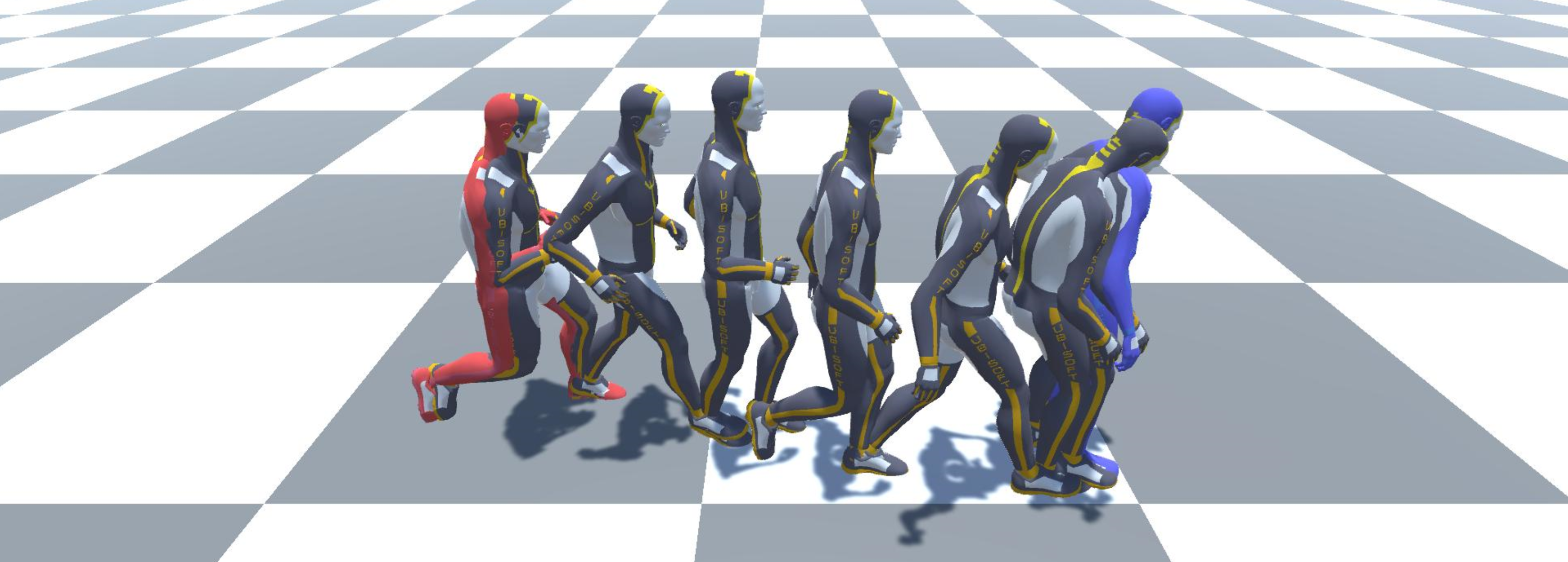

| Jul 15, 2022 | Our paper Conditional Motion In-Betweening has been accepted in the Pattern Recognition Journal by Elsevier. |